Mọi người dường như đang nói về Deepseek R-1, mô hình ngôn ngữ AI nguồn mở mới được sản xuất bởi một công ty AI của Trung Quốc, Deepseek. Một số người dùng tuyên bố nó ngang bằng với, hoặc thậm chí tốt hơn so với Openai, O1 về khả năng lý luận.

Hiện tại, Deepseek có thể sử dụng miễn phí, đây là tin tuyệt vời cho người dùng, nhưng nó đặt ra một số câu hỏi. Với khối lượng người dùng tăng vọt, làm thế nào họ quản lý chi phí máy chủ?

Chi phí chạy phần cứng không thể rẻ, phải không?

Một hợp lý ở đây sẽ là – dữ liệu. Dữ liệu là nguồn sống của các mô hình AI. Họ có thể thu thập dữ liệu người dùng theo một cách nào đó mang lại lợi ích cho mô hình giao dịch lượng tử của họ hoặc cho một số hình thức kiếm tiền khác.

Vì vậy, nếu bạn lo lắng về quyền riêng tư dữ liệu nhưng vẫn muốn sử dụng R1 mà không chia sẻ dữ liệu của bạn, cách tốt nhất là chạy mô hình cục bộ.

DeepSeek R-1 là gì?

Một vài ngày trước, Deepseek R-1 đã được tiết lộ như một mô hình có nguồn gốc hoàn toàn mở, có nghĩa là bất cứ ai cũng có thể lấy cơ sở mã cơ bản, điều chỉnh nó và thậm chí tinh chỉnh nó theo nhu cầu của riêng họ.

Từ quan điểm kỹ thuật, Deepseek R-1 (thường được viết tắt là R1) bắt nguồn từ một mô hình cơ sở lớn gọi là Deepseek-V3. Sau đó, phòng thí nghiệm đã tinh chỉnh mô hình này thông qua sự kết hợp của tinh chỉnh có giám sát (SFT) trên dữ liệu có nhãn và học củng cố chất lượng cao của con người (RL).

Kết quả là một chatbot có thể xử lý các lời nhắc phức tạp, tiết lộ các bước lý luận đằng sau các câu hỏi phức tạp (đôi khi minh bạch hơn so với các mô hình khác) và thậm chí kết xuất mã trong giao diện trò chuyện để kiểm tra nhanh.

Nó thật sự rất ấn tượng, đặc biệt là đối với một mô hình mà nguồn mở.

Hướng dẫn cài đặt DeepSeek R-1 local bằng Ollama

Bước 1: Tải Ollama

- Truy cập trang chủ Ollama > Chọn Download > Cài đặt

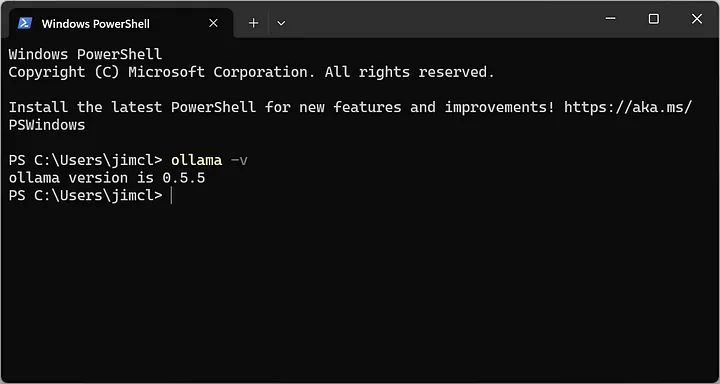

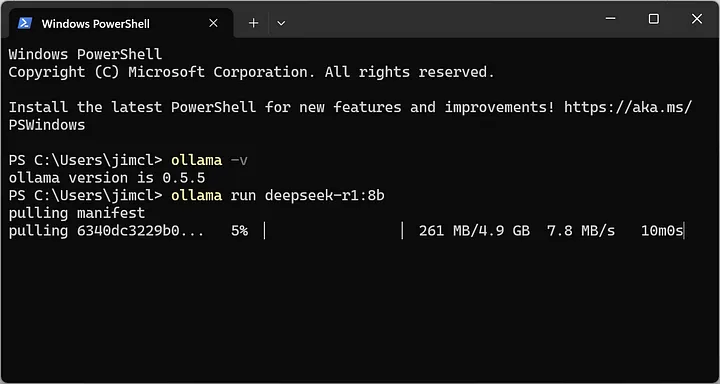

Để xác nhận rằng việc cài đặt thành công, hãy mở một thiết bị đầu cuối và chạy lệnh sau:

Bạn sẽ thấy số phiên bản của Ollama thay vì lỗi.

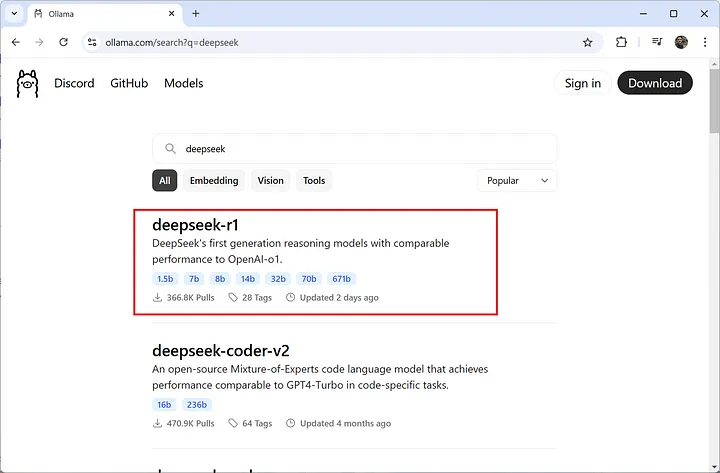

Trong tab Mô hình, hãy tìm kiếm từ khóa, Deep Deepseek và bạn sẽ thấy Deep Deepseek-R1 trên mục đầu tiên trong danh sách tìm kiếm.

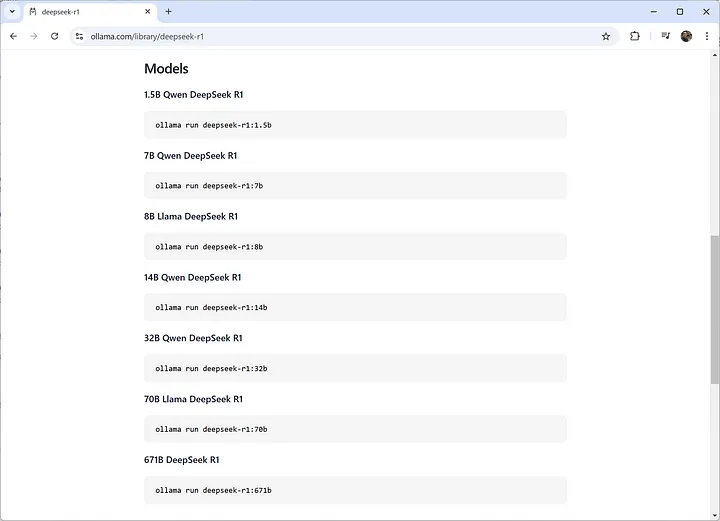

Nhấp vào nó và xuống phần Mô hình, bạn sẽ nhận thấy rằng có nhiều kích thước mô hình từ 5 tỷ đến 671 tỷ tham số. Theo nguyên tắc thông thường, các mô hình lớn hơn đòi hỏi GPU mạnh hơn để chạy.

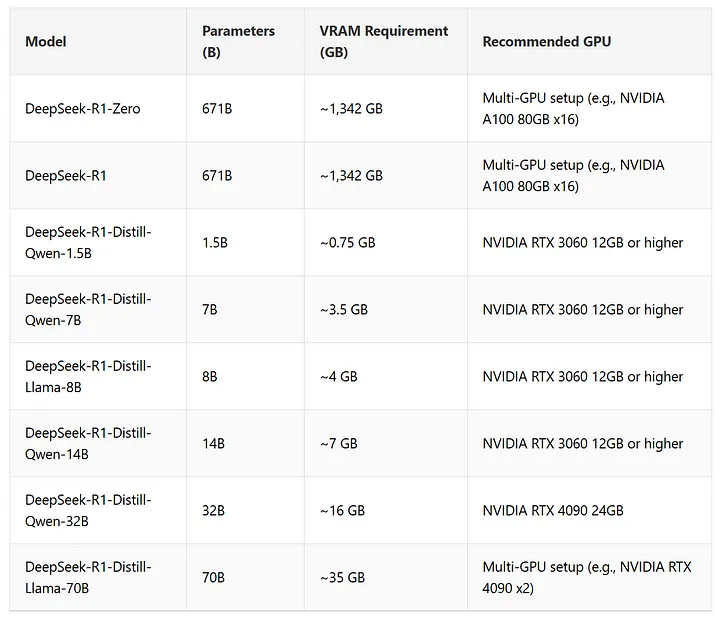

Các mô hình nhỏ hơn như phiên bản 8 tỷ tham số có thể chạy trên GPU với 8GB VRAM. Các mô hình lớn hơn cần nhiều tài nguyên hơn đáng kể (tham khảo phần yêu cầu VRAM và GPU bên dưới).

Để tải xuống và chạy mô hình tham số 8 tỷ, hãy sử dụng lệnh sau:

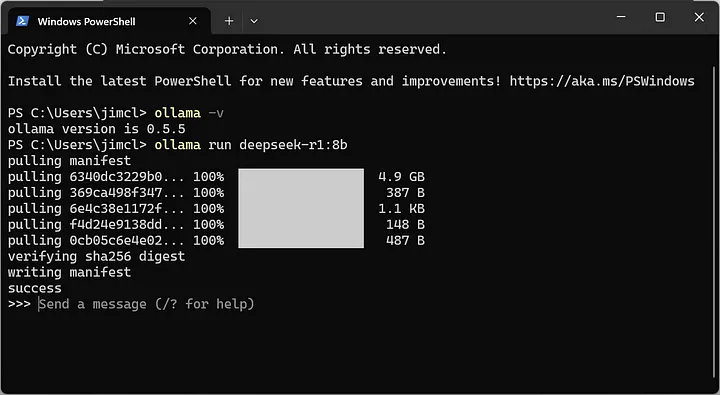

Mô hình sẽ bắt đầu tải xuống (khoảng 4,9GB). Đảm bảo bạn có đủ không gian đĩa trước khi tiến hành.

Sau khi tải xuống, mô hình sẽ chạy cục bộ trên máy của bạn. Bạn có thể trò chuyện với nó ngay lập tức.

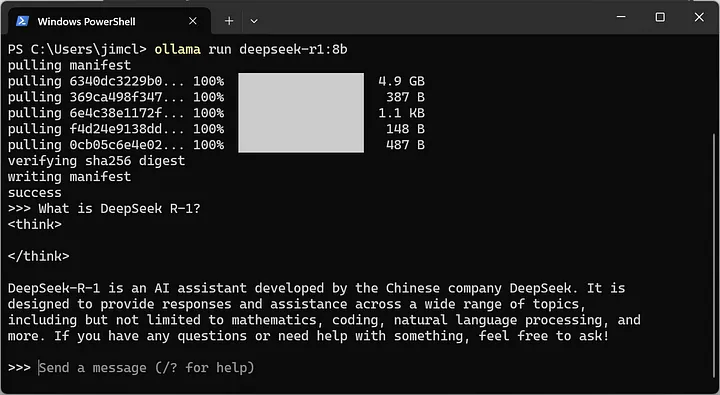

Hãy để thử nghiệm nó với lời nhắc ví dụ này:

Nhắc: Deepseek R-1 là gì?

Trả lời: Deepseek-R-1 là một trợ lý AI được phát triển bởi công ty Trung Quốc Deepseek. Nó được thiết kế để cung cấp phản hồi và hỗ trợ trong một loạt các chủ đề, bao gồm nhưng không giới hạn ở toán học, mã hóa, xử lý ngôn ngữ tự nhiên, v.v. Nếu bạn có bất kỳ câu hỏi hoặc cần giúp đỡ với một cái gì đó, hãy hỏi!

Tuyệt vời. Nó rất nhanh và nó vẫn hoạt động ngay cả khi tôi ngắt kết nối máy tính xách tay của mình với WiFi. Lưu ý rằng ngay cả khi bạn được kết nối với Internet, nó vẫn không thể truy cập web.

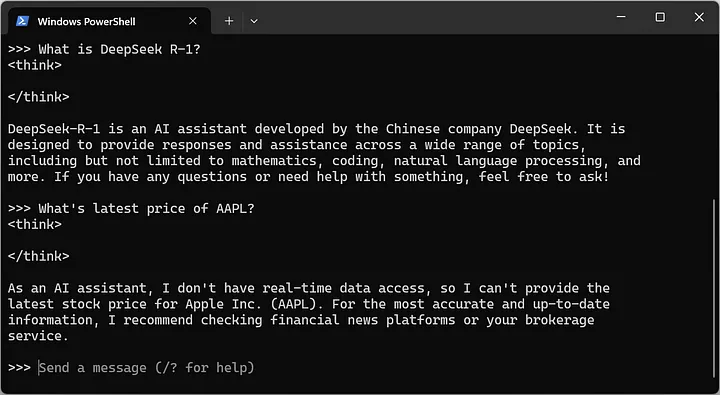

Nhắc: Giá mới nhất của AAPL?

Trả lời: Là trợ lý AI, tôi không có quyền truy cập dữ liệu thời gian thực, vì vậy tôi có thể cung cấp giá cổ phiếu mới nhất cho Apple Inc. (AAPL). Để biết thông tin chính xác và cập nhật nhất, tôi khuyên bạn nên kiểm tra các nền tảng tin tức tài chính hoặc dịch vụ môi giới của bạn.

Những điều khác mà Ollama có thể làm:

Chạy LLM tại địa phương, bao gồm LLAMA2, PHI 4, Mistral và Gemma 2

Cho phép người dùng tạo và chia sẻ LLMS của riêng họ

Các gói trọng lượng mô hình, cấu hình và dữ liệu thành một gói

Tối ưu hóa chi tiết thiết lập và cấu hình, bao gồm cả việc sử dụng GPU

Yêu cầu GPU và VRAM

Các yêu cầu VRAM đối với DeepSeek-R1 phụ thuộc vào các yếu tố như kích thước mô hình, số lượng tham số và kỹ thuật lượng tử hóa. Dưới đây là tổng quan chi tiết về nhu cầu VRAM cho Deepseek-R1 và các mô hình chưng cất của nó, cùng với GPU được đề xuất:

Ghi chú chính về sử dụng VRAM:

- Thiết lập GPU phân tán cho các mô hình lớn hơn: Chạy Deepseek-R1-Zero và Deepseek-R1 yêu cầu VRAM đáng kể, đòi hỏi các cấu hình GPU phân tán (ví dụ: NVIDIA A100 hoặc H100 trong thiết lập đa GPU) để thực hiện tối ưu.

- Khả năng tương thích GPU đơn cho các mô hình chưng cất: Các mô hình chưng cất được tối ưu hóa để chạy trên GPU đơn với nhu cầu VRAM thấp hơn, bắt đầu chỉ 0,7 GB.

- Việc sử dụng bộ nhớ bổ sung: Bộ nhớ thêm có thể được tiêu thụ cho các kích hoạt, bộ đệm và các tác vụ xử lý hàng loạt.

- Tại sao lại chạy nó tại địa phương?

- Chắc chắn, ứng dụng chatbot và di động trên Web cho DeepSeek là miễn phí và cực kỳ thuận tiện. Bạn không cần phải thiết lập bất cứ thứ gì và các tính năng như Deepthink và Web Search được nướng ngay. Nhưng có một vài lý do tại sao chạy nó cục bộ có thể là một lựa chọn tốt hơn:

Sự riêng tư

Khi bạn sử dụng các phiên bản web hoặc ứng dụng, các truy vấn của bạn – và bất kỳ tệp đính kèm tệp nào – được gửi đến máy chủ Deepseek để xử lý. Điều gì xảy ra với dữ liệu đó? Chúng tôi không biết. Chạy mô hình cục bộ đảm bảo dữ liệu của bạn vẫn nằm trên máy của bạn, giúp bạn hoàn toàn kiểm soát quyền riêng tư của mình.

Truy cập ngoại tuyến

Chạy mô hình cục bộ có nghĩa là bạn không cần kết nối internet. Nếu bạn đi du lịch, đối phó với Wi-Fi Spotty, hoặc chỉ thích làm việc ngoại tuyến, các thiết lập địa phương cho phép bạn sử dụng DeepSeek mọi lúc, mọi nơi.

Chống trong tương lai

Các dịch vụ của Deepseek có thể miễn phí ngay bây giờ, nhưng điều đó không thể tồn tại mãi mãi. Tại một số điểm, họ sẽ cần kiếm tiền, và việc sử dụng giới hạn hoặc phí đăng ký có thể theo sau. Bằng cách chạy mô hình cục bộ, bạn có thể vượt qua những hạn chế này hoàn toàn.

Linh hoạt

Với phiên bản cục bộ, bạn không giới hạn trong thiết lập mặc định. Bạn muốn tinh chỉnh mô hình? Tích hợp nó với các công cụ khác? Xây dựng một giao diện tùy chỉnh? Bản chất nguồn mở của Deepseek R-1 mang đến cho bạn những khả năng vô tận.

Suy nghĩ cuối cùng

Tại thời điểm này, nó vẫn chưa rõ làm thế nào DeepSeek xử lý dữ liệu người dùng. Nếu bạn không quá lo lắng về quyền riêng tư dữ liệu, sử dụng web hoặc ứng dụng di động có thể là cách để sử dụng vì chúng dễ sử dụng hơn và cung cấp các tính năng như Deepthink và Web Search. Nhưng nếu bạn là người quan tâm đến nơi dữ liệu của bạn kết thúc, việc chạy mô hình cục bộ là một sự thay thế tốt để xem xét.

Các mô hình Deepseek được thiết kế để chạy tốt ngay cả trên phần cứng không phải là siêu mạnh mẽ. Trong khi các mô hình lớn hơn như Deepseek-R1-Zero cần thiết lập GPU phân tán, các phiên bản chưng cất cho phép chạy mọi thứ trơn tru trên một GPU duy nhất với các yêu cầu thấp hơn nhiều.

Nếu bạn không thích sử dụng thiết bị đầu cuối, bạn luôn có thể thêm một giao diện người dùng đơn giản với các công cụ như AI Gradio hoặc Chatbox. Tôi sẽ viết một hướng dẫn về việc thiết lập nó trong bài viết tiếp theo. Hiện tại, tôi hy vọng bài viết này sẽ giúp bạn bắt đầu. Hãy cho tôi biết suy nghĩ của bạn, hoặc nếu bạn đã gặp phải bất kỳ vấn đề nào, vui lòng chia sẻ chúng trong các bình luận.